先做个广告:如需代注册ChatGPT或充值 GPT4.0会员(plus),请添加站长微信:gptchongzhi

一、o1系列模型概况

推荐使用GPT中文版,国内可直接访问:https://ai.gpt86.top

推荐使用GPT中文版,国内可直接访问:https://ai.gpt86.top

9月13日OpenAI宣布发布o1系列模型,o1系列模型包括o1、o1-mini以及抢先版o1-preview,o1-preview和o1-mini模型已经可以使用。OpenAI宣布,“新模型在推理能力上代表了人工智能能力的新水平,因此,计数器将重置为1”。

根据OpenAI的自测,o1在竞赛编程问题(Codeforces)中排名第89个百分点,在美国数学奥林匹克竞赛(AIME)预选赛中位列美国前500名学生之列,并且在物理、生物和化学问题的基准测试(GPQA)中超过了人类博士水平的准确度。

OpenAI团队上下对o1模型充满了信心,OpenAI的CEO 山姆·奥特曼在社交媒体上表示:“需要耐心等待的时刻结束了!”、“这是我们至今为止最强大、最一致的一系列模型。“。

根据OpenAI的公开文档,o1主要利用了强化学习和思维链两种技术。首先,利用强化学习技术,通过奖惩训练o1自行寻找答案,o1会尝试不同的策略,发现自己的错误,并修改策略;其次,在解答问题时,再采用思维链技术,将复杂问题分解为多个连续关联的简单问题,类似于人类逐步解决问题的方式。

这使得o1的训练方式与之前的AI模型有着根本不同,OpenAI使用了一种全新的优化算法和专门为其量身定制的新训练数据集进行训练,包括“推理数据”和专门为其量身定制的科学文献。

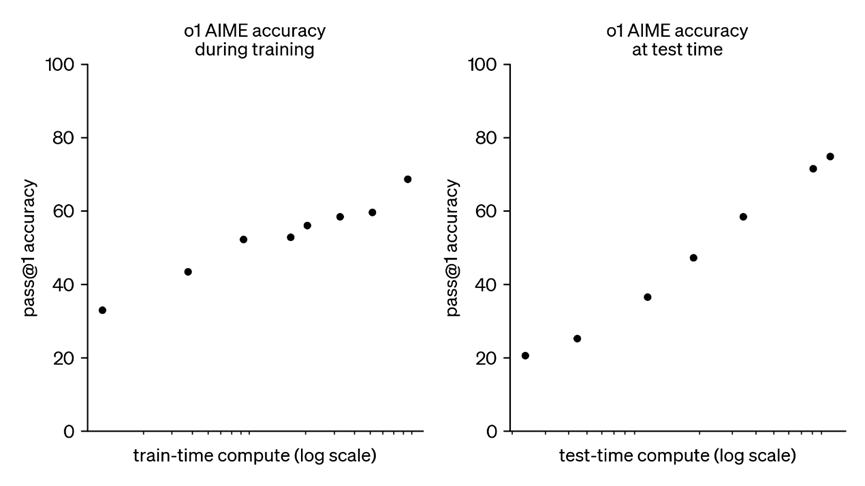

OpenAI发现,o1 模型通过训练时和测试时,准确性会随时间平稳提高,思考越久质量越高,安全性越高。借助新的训练方法,o1模型会更加准确,AI幻觉问题减少,但依然存在,而且通过对上下文的关联分析,获得了更高的“越狱测试”分值。

而且在绝大多数这些推理密集型任务中,比如数学计算、代码编程,以及测试化学、物理和生物学专业知识的基准GPQA-diamond上,o1 系列模型的性能均明显优于 GPT-4o。

根据OpenAI公布的信息,o1系列模型的特长并不相同,从数学能力看,o1最强,其次是o1-mini,最后是o1-preview,从成本看,o1最高,其次是o1-preview,最便宜是o1-mini。o1擅长准确生成和调试复杂代码,o1-preview具有较强的推理能力和广阔的世界知识,o1-mini速度更快、比o1-preview便宜80%的推理模型,在编程方面尤其高效。

但o1系列模型在关于世界的事实知识方面总体表现不佳,甚至不如GPT-4o等之前模型,需要更长时间、更高成本来回答问题,目前也缺乏从网络收集实时信息的能力,更易产生幻觉。

二、社会评测与同行水平

社会评测普遍认可o1 系列模型的逻辑推理能力优于 GPT-4o,但也有很多人提出了不同看法。

差评XPIN邀请了理综三科的博士测评,物理评价较高,而生物、化学评价较低,综合认为o1在认知上达到硕士水平,但创造力上仍远远达不到硕博水平。

文章地址:https://mbd.baidu.com/newspage/data/landingsuper?context=%7B%22nid%22%3A%22news_9103761019903209191%22%7D&n_type=1&p_from=4

APPSO认为o1做题能力强,但复杂的生活场景推理仍不尽如人意。

文章地址:https://m.huxiu.com/article/3465156.html

每日经济新闻通过评测发现,o1在经典草莓测试、代码编写、小游戏制作、数学与经济学表现出色,对事实性知识与语言理解上表现反而不如GPT-4o。

文章地址:https://baijiahao.baidu.com/s?id=1810084250835787270&wfr=spider&for=pc

赛博禅心从o1输出语言风格分析,认为 o1“与其说是模型优化,不如说是工程优化”。

文章地址:https://www.sohu.com/a/808623091_121124377

此外,在o1发布之前,谷歌AI研究实验室DeepMind在7月底宣布,其AI系统在今年国际数学奥林匹克(IMO)中首次取得与银牌得主同等的成绩, Anthropic在 6月推出了Claude 3.5 Sonnet模型,在推理、编码等测试中的得分也超过了GPT-4o,竞争对手的AI模型与o1差距并不远。

三、AlphaGo模型借鉴

OpenAI并没有公布oI的模型特征,只公布了利用了强化学习和思维链两种技术,思维链是由谷歌在2022 年提出,oI是第一个实现的,这是将复杂问题简化的方法。

但最为重要的是强化学习技术,强化学习的前驱是DeepMind的AlphaGo。

AlphaGo以前的围棋算法采用的是蒙特卡洛树搜索,试图利用计算机的算力优势进行海量模拟试错,但围棋人工智能也只能战胜业余棋手。

AlphaGo的成功取决于开发出了价值网络,将价值网络、策略网络和蒙特卡洛树搜索组合在一起,策略网络是指预测可能走法的概率分布,价值网络是指估计游戏状态的价值,蒙特卡洛树搜索是游戏树的核心搜索算法。

对于围棋而言,搜索的复杂度取决于搜索空间的宽度(每步的选择多寡)和深度(博弈的步数),围棋棋面有361个点,平均宽度约为250,深度约为150,AlphaGo用价值网络(value network)消减深度,用策略网络(policy network)消减宽度,利用局面评估函数,极大地缩小了蒙特卡洛树的搜索范围,提高了算法的成功概率。

AlphaGo用了一个13层的深度卷积神经网络来训练价值网络和策略网络,将棋盘每个位置编码48种经验特征,通过“自我对战”来进行深度学习,识别每个位置的隐含特征,积累了2000万盘高质量对局作为大数据基础。

机器学习的优点是通过人力所无法企及的海量运算,把人类说不清楚的复杂逻辑训练出来,放在多层神经网络海量系数里,以此改善价值网络、策略网。

此外,AlphaGoV18算力也有了极大提升,在以4:1胜李世石比赛中,使用的分布式机器有1202个CPU和176个GPU。围棋人工智能的算法、算力均获得了大幅提升,从而战胜了人类最高水平的棋手。

三、oI模型分析

oI必定会像AlphaGo那样设立目标,给出胜负规则,然后才能通过奖惩训练o1,o1才能通过蒙特卡洛树搜索,发现高价值答案,从而修改策略,不断自我积累与改进。

从数学、物理、化学、生物等学科看,oI在数学、物理等学科上,目标与胜负规则设定较为简单、明确,因此o1相比GPT-4o进步明显,但在化学、生物等学科上,目标与胜负规则设定相对较为复杂、模糊,因此训练成绩相对没有那么突出。这可能与化学、生物需要大量知识点的理解有关,o1在对事实性知识与语言理解上表现不如GPT-4o。

虽然AlphaGo可以在围棋比赛中战胜人类冠军,人工智能可以在大规模图像识别和人脸识别超越了人类的水平,人工智能系统诊断皮肤癌可以达到专业医生水平,但都是在需求明确、边界清晰、逻辑简单的前提下,也就是概念模型较为简单的前提下,人工智能可以利用算力优势超过人类,但当时人工智能在复杂逻辑推理、抽象概念理解上,还存在明显的局限性。

数学、物理和围棋虽然都强调逻辑思维,但侧重点不同。围棋侧重于空间布局和策略选择。数学、物理的基本概念和公理构成了一个演绎系统,通过这些基本元素推导出复杂的定理和公式,定理和公式具有唯一性和确定性。围棋中的走法往往有很多种可能性,数学、物理题的解法虽然也存在有多种可能,但在策略网络的宽度、价值网络的深度选择上要大大少于围棋,所以数学、物理的深度学习难度并不比围棋高。

数学、物理题的真正难点在于以数据驱动的暴力策略无法模拟人类的常识推理,比如向AI提问“如果一根香蕉重0.5磅,而我有7磅香蕉和9个橙子,我总共有多少个水果?“具有小学文化的人可以算出答案是23个水果。AI却回答:“你有16个水果、7根香蕉和9个橙子。” AI没有建立出对概念的精确认知,导致了数字的简单堆积。

o1的新训练数据集必定包括了精确的科学文献数据,与专业的推理数据,从而大大增强了o1的常识推理能力,因此才能在逻辑推理能力上胜过了GPT-4o。

四、oI模型的内在缺陷

但OpenAI o1的强化学习还没有实现真正的逻辑推理能力,逻辑推理能力是一种根据事物概念的内涵、外延与发展变化,推理出事物之间逻辑关系的能力,拥有真正的逻辑推理能力其实并不需要太多算力进行暴力计算。

o1通过奖惩训练进行大量强化学习,说明其虽然通过科学文献数据与推理数据,提升了AI的常识推理能力,但仍不足以建立AI对事物概念的内涵、外延与发展变化的准确认知,还需要通过大量具有目标、奖惩规则的学习进行修正,如果脱离了这些目标、奖惩规则,AI无法基于这些训练出来的逻辑在另一个领域进行准确的逻辑推理,这其实是“AI逻辑假象”,AI并没有准确认知事物背后的逻辑,只是通过大量学习构建出了已知领域事物的固有逻辑关系,而其他领域难以照搬与应用这些逻辑关系。

所以o1模型其实只是掌握已知领域固有逻辑关系的解题家,而非掌握普适逻辑的逻辑家!

网友评论