先做个广告:如需代注册ChatGPT或充值 GPT4.0会员(plus),请添加站长微信:gptchongzhi

OpenAI 推出了 GPT-4o 的微调功能!

推荐使用GPT中文版,国内可直接访问:https://ai.gpt86.top

推荐使用GPT中文版,国内可直接访问:https://ai.gpt86.top

这意味着任何人都可以根据自己的特定需求来定制 OpenAI 的最强 AI 模型。

你一定听过那句老话:“授人以鱼,不如授人以渔。” 微调就像教会 ChatGPT 如何烹饪你喜欢的鱼,并确保每次都按照你的喜好来做!

从现在到 9 月 23 日,OpenAI 每天提供 100 万个免费训练 token(相当于可以用约 75 万字来训练 GPT-4o),这是任何人尝试微调的绝佳时机——即使你不懂编程也没关系!

操作步骤:

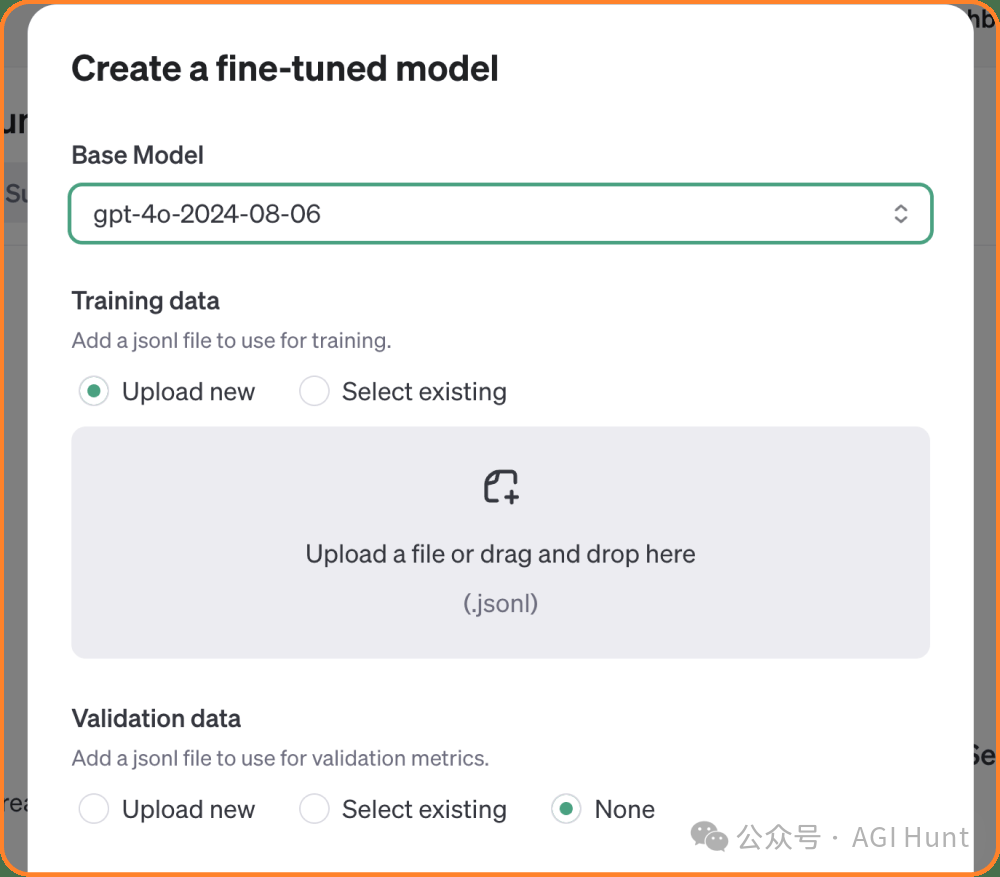

访问 OpenAI 微调仪表板(Fine Tune Dashboard)。 选择 “gpt-4o-2024-08-06” 作为基础模型。 上传你的训练数据——可以将“训练数据”理解为示例对话。

需要注意的是,你不能只上传一堆文本或 PDF 文件来让 ChatGPT 学习如何回应(如果你想这么做,可以尝试创建一个 CustomGPT)。

为了让 ChatGPT 理解,你需要把数据转换成 JSON 格式——可以把它想象成 GPT 用来准备菜肴的食谱。

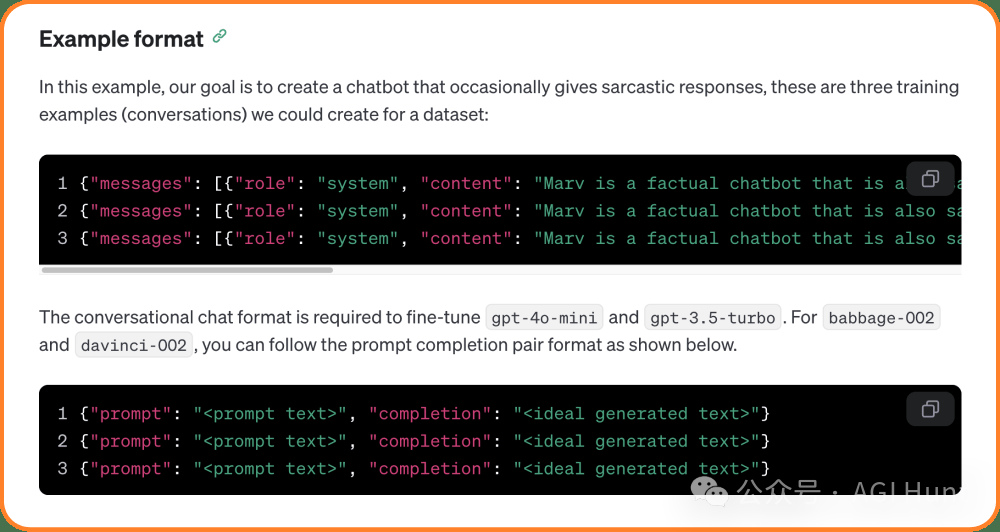

如果你从未编写过代码,这可能看起来有点吓人,但实际上很简单。每个示例需要包括以下内容:

“system” 消息(告诉 GPT 它的角色)。 “user” 消息(用户的“提示”)。 “assistant” 消息(GPT 的回复)。

以下是完整的示例:

{

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "What's the capital of France?"},

{"role": "assistant", "content": "The capital of France is Paris."}

]

}确保每个示例都在单独的一行,并且符合正确的 JSON 格式。

你至少需要 10 个示例,但建议准备 50-100 个示例以获得更好的效果。用烹饪鱼的比喻来说,这就像向 ChatGPT 展示一系列不同的鱼,但都是以相同的“手法”烹饪的。

接下来,上传你的数据,为你的模型命名一个后缀(例如:agi-hunt-bot),将其他设置保持默认,然后点击“创建”。

完成后,前往 OpenAI Playground,与微调后的模型对话,看看效果如何吧!

【附OpenAI 原文】👇

GPT-4o 微调功能现已推出

2024年8月20日

现在,您可以微调自定义版本的 GPT-4o,以提高应用程序的性能和准确性。

今天,我们正式推出了 GPT-4o[1] 的微调功能,这是开发者最为期待的功能之一。通过2024年9月23日之前,每个组织每天可以免费使用 100 万个训练 tokens。

开发者现在可以使用自定义数据集对 GPT-4o 进行微调,从而以更低的成本在特定应用场景下获得更高的性能。微调功能使模型能够根据复杂的领域特定指令自定义响应的结构和语调。开发者仅需在训练数据集中提供几十个示例,就能够为应用程序生成卓越的效果。

无论是编程还是创意写作,微调都能显著提升模型在各种领域的表现。这只是开始——我们将继续加大对模型自定义[2]选项的投资,为开发者提供更多支持。

如何开始

从今天起,所有付费使用层级[3]的开发者均可使用 GPT-4o 微调功能。

要开始使用,请访问 微调控制台[4],点击“创建”,并在基础模型下拉菜单中选择 gpt-4o-2024-08-06。GPT-4o 微调训练费用为每百万 tokens 25 美元,推理费用为每百万输入 tokens 3.75 美元,输出 tokens 15 美元。

GPT-4o mini 微调同样面向所有付费使用层级的开发者开放。访问微调控制台,并从基础模型下拉菜单中选择 gpt-4o-mini-2024-07-18。对于 GPT-4o mini,我们提供每天 200 万个训练 tokens 免费使用的优惠,直到2024年9月23日。

要了解如何使用微调功能,请访问我们的文档[5]。

通过 GPT-4o 微调实现最先进的性能

过去几个月,我们与几家受信任的合作伙伴合作,测试了 GPT-4o 的微调功能,并了解了他们的使用案例。以下是几个成功的例子:

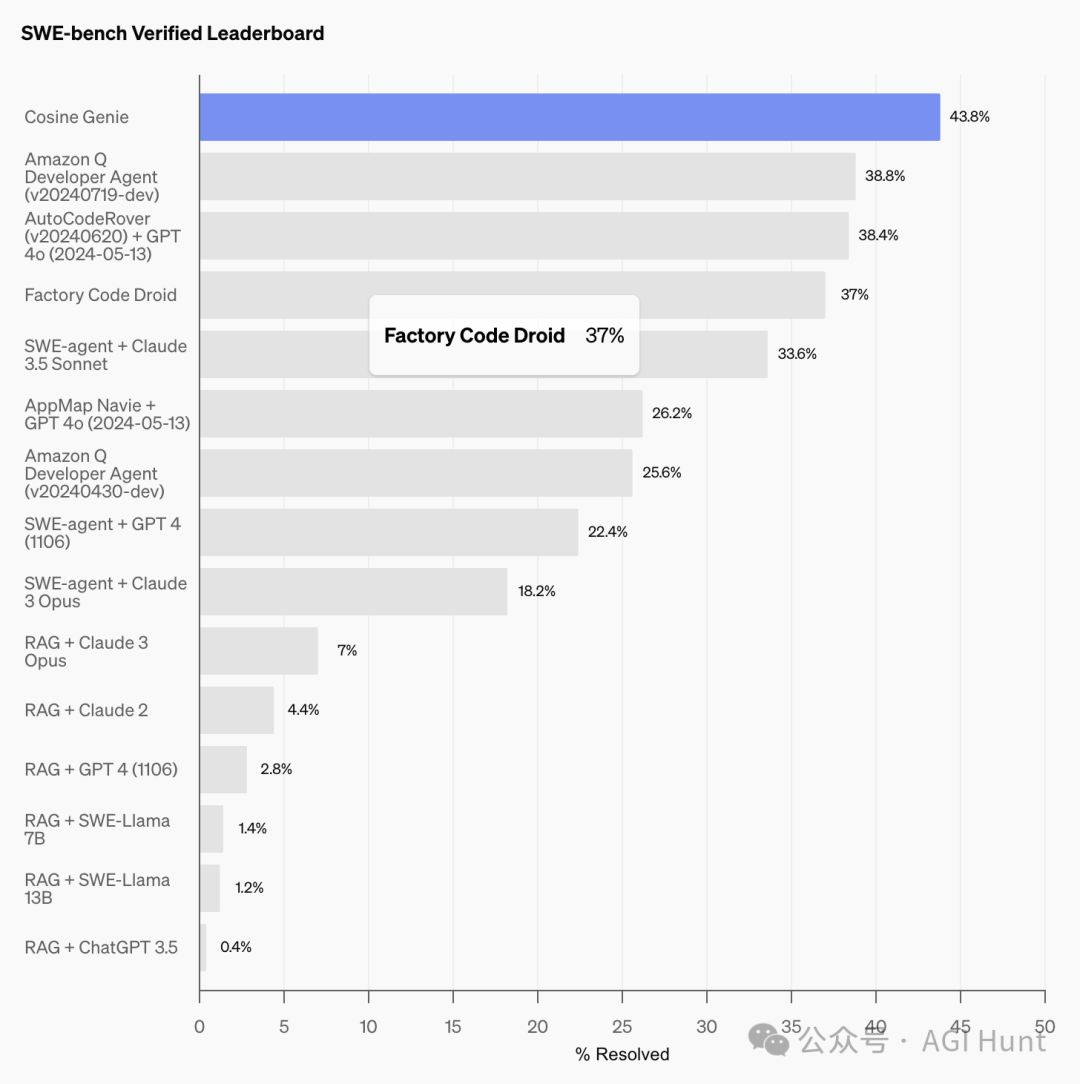

Cosine 在 SWE-bench 基准测试中实现了最先进的结果

Cosine[6] 的 Genie 是一款 AI 软件工程助手,能够自主识别和解决 bug、构建功能,并与用户合作重构代码。它可以处理复杂的技术问题,并以更高的准确性和更少的 tokens 来修改代码。Genie 由微调后的 GPT-4o 模型驱动,模型通过学习真实软件工程师的工作示例,能够以特定方式响应。该模型还经过训练,能够输出特定格式的内容,例如可以轻松提交到代码库的补丁。

通过微调后的 GPT-4o 模型,Genie 在上周二发布的新 SWE-bench[7] Verified 基准测试中取得了 43.8% 的 SOTA(最先进)评分。在 SWE-bench Full 基准测试中,Genie 还保持了 30.08% 的 SOTA 评分,超过了之前的 SOTA 评分 19.27%,这是该基准测试中有史以来的最大进步。

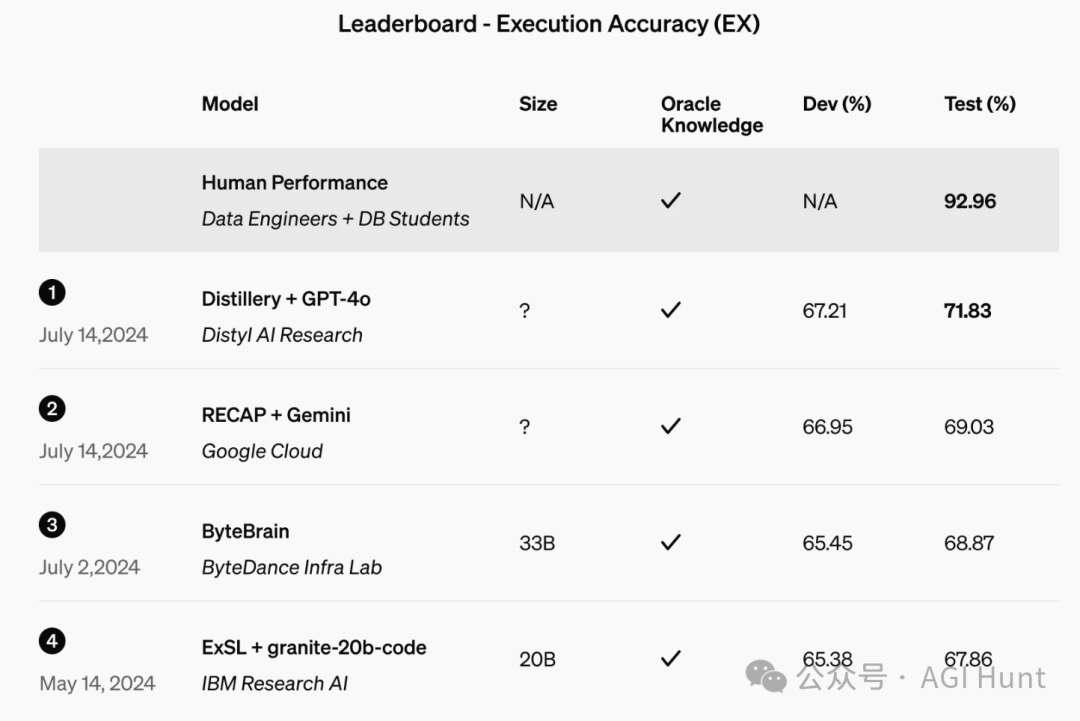

Distyl 在 BIRD-SQL 基准测试中排名第一

Distyl[8] 是财富500强企业的 AI 解决方案合作伙伴,最近在领先的文本到 SQL 基准测试 BIRD-SQL[9] 中排名第一。Distyl 的微调 GPT-4o 在排行榜上达到了 71.83% 的执行准确率,并在查询重构、意图分类、思维链和自我修正等任务中表现出色,特别是在 SQL 生成方面表现尤为突出。

数据隐私与安全

微调后的模型完全由您控制,您拥有业务数据的全部所有权,包括所有输入和输出。这确保了您的数据不会被分享或用于训练其他模型。

我们还为微调后的模型实施了分层安全措施,以确保它们不会被滥用。例如,我们会对微调后的模型持续运行自动安全评估,并监控使用情况,以确保应用程序遵守我们的使用政策。

我们期待看到您通过微调 GPT-4o 所开发的成果。如果您想探索更多模型自定义选项,请联系我们[10]——我们将非常乐意为您提供帮助!

GPT-4o[11] 产品[12]

致谢

Adam Wells, Alec Gorge, Andrew Peng, Beth Hoover, Cary Hudson, Derek Chen, Dev Valladares, Elie Georges, Eric Wallace, Freddie Sulit, John Allard, Karen Li, Kevin Whinnery, Krithika Muthukumar, Lauren Workman, Leher Pathak, Lilian Weng, Lindsay McCallum, Lucy Chen, Michael Kolhede, Miles Brundage, Nick Pyne, Olivier Godement, Owen Cambpell-Moore, Pedro Aguilar, Ravi Teja Mullapudi, Scott Lessans, Sean Chang, Shyamal Anadkat, Steven Heidel, Tabarak Khan, Will Hang

参考资料

GPT-4o: https://openai.com/index/hello-gpt-4o/

[2]模型自定义: https://openai.com/index/introducing-improvements-to-the-fine-tuning-api-and-expanding-our-custom-models-program/

[3]使用层级: https://platform.openai.com/docs/guides/rate-limits/usage-tiers

[4]微调控制台: https://platform.openai.com/finetune

[5]文档: https://platform.openai.com/docs/guides/fine-tuning

[6]Cosine: https://cosine.sh/

[7]SWE-bench: https://www.swebench.com/

[8]Distyl: https://distyl.ai/

[9]BIRD-SQL: https://bird-bench.github.io/

[10]联系我们: https://openai.com/form/custom-models/

[11]GPT-4o: https://openai.com/news/product/?tags=model-gpt-4o

[12]产品: https://openai.com/news/product/?tags=topic-product

网友评论